Классификация дублей

Различают следующие типы дублированных страниц:

- неполные. Они копируют отдельные части размещенной на сайте информации. В частности, дубли контента возникают при размещении одних и тех же абзацев текста на разных страницах;

- полные. Дублированные страницы этого типа представляют собой полные копии оригинальных со всем размещенным на них контентом. Они негативно сказываются на ранжировании веб-ресурса.

К примеру, дублированные страницы часто можно встретить в блогах. Они ухудшают ранжирование и обесценивают информационное наполнение сайта, из-за чего их обязательно нужно обнаруживать и удалять.

Причины возникновения дублированных страниц

Применение систем управления контентом (CMS). Это самая распространенная причина образования дублей страниц на сайте. Такое случается, например, если одна запись размещается в нескольких разделах, домены которых включены в URL ее веб-ресурса. К примеру:

wiki.site.ru/blog1/info/

wiki.site.ru/blog2/info/

Технические разделы. Такие ситуации чаще всего происходят с системами управления содержимым Bitrix и Joomla. В частности, когда некоторые функции веб-ресурса (поиск, фильтрация, регистрация и т. д.) создают параметрические адреса с идентичной информацией относительно сайта без характеристик в URL. К примеру:

site.ru/rarticles.php

site.ru/rarticles.php?ajax=Y

Человеческая ошибка. Часто дублирование статей в различных разделах веб-ресурса происходит из-за невнимательности, проявленной человеком, который отвечает за его информационное наполнение.

Технические ошибки. Из-за некорректно настроенного генератора гиперссылок и других опций в CMS происходят сбои, приводящие к появлению страниц-копий. В частности, неправильно установленная ссылка в системе OpenCart провоцирует зацикливание типа

site.ru/tools/tools/tools/…/…/…

Последствия дублирования страниц

- Большие трудности с оптимизацией веб-ресурса в поисковиках. В индексе поисковой системы возможно появление множества копий, которые затрудняют индексацию прочих страниц.

- Потеря внешних гиперссылок на сайт. Дубликаты затрудняют выявление релевантных страниц.

- Появление дублированных страниц в выдаче. Если источник-дубль имеет метрики поведения ЦА и большой трафик, то в процессе обновления данных он займет в поисковой выдаче позицию основного сайта.

- Утрата позиции в выдаче. При наличии в основном тексте неполных дублей из-за сниженной уникальности он, вероятно, не попадет в SERP. В частности, фрагменты новостей, блога, поста и прочего часто не замечаются поисковой системой, так как она воспринимает их как копии.

- Риск попадания сайта под фильтр. Google и Яндекс принимают меры для уменьшения неуникального контента, из-за чего к ресурсу с дубликатами страниц применяются санкции.

Выявление дублей страниц

Для удаления дублированных страниц их предварительно нужно обнаружить, для чего используются следующие методики.

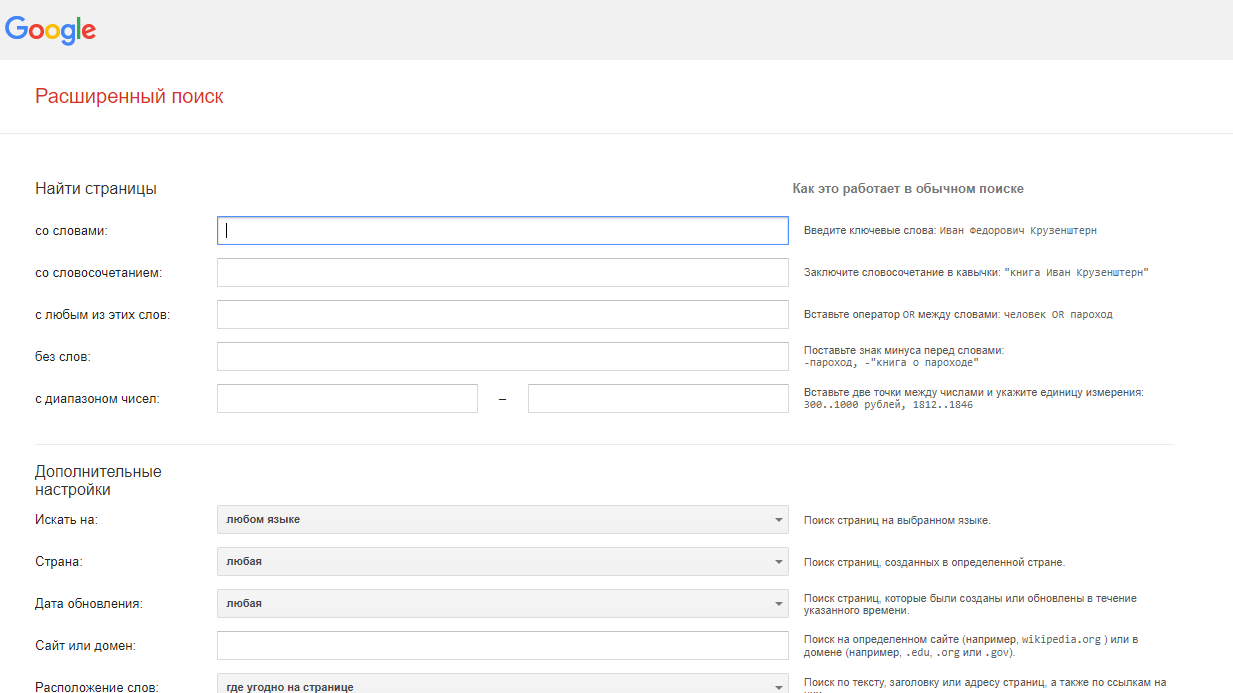

- Через расширенный поиск Google. Для этого необходимо указать в нем адрес главной страницы сайта, и система покажет проиндексированные страницы. При указании URL конкретной страницы поисковик выдаст полный перечень проиндексированных копий. Поисковая система Яндекс сразу показывает дубли на сайте. Расширенный поиск Google выглядит следующим образом:

При наличии большого числа страниц на сайте разделите их на классы (описания товаров, информационные статьи, блог, новостной раздел и прочее) – это сделает анализ более быстрым.

- С помощью программы XENU (Xenu Link Sleuth). Она помогает осуществить аудит веб-ресурса и обнаружить дублированные страницы. Для получения аудита и фильтрации по заголовку нужно указать адрес сайта в специальной строке – программа выявит полные копии. Но с ее помощью нельзя обнаружить частичные дубли.

- Через веб-мастерскую Google. Пройдите регистрацию в этом сервисе, и в его разделе «Оптимизация Html» появится список страниц с дублированным наполнением, тегами <Title>. В этой таблице легко обнаруживаются полные копии. Как и в предыдущем случае, данный способ не позволяет найти частичные дубли.

- С помощью онлайн-сервиса Serpstat. Эта SEO-платформа выполняет технический SEO-аудит веб-ресурса по 55+ ошибкам, в том числе анализирует сайт на наличие повторяющейся информации. Например, сервис выявит продублированные Title, Description, H1 на 2 и более страницах. Также он обнаруживает дублирование заголовком H1 тега Title, ошибочно размещенные на одной и той же странице 2 тега Title и больше 1 заголовка Н1. Для проведения аудита в Serpstat необходимо пройти в нем регистрацию и создать соответствующий проект.

Удаление дублей

От обнаруженных дублированных страниц нужно избавиться, а также определить причины их образования и предотвратить распространение. Для устранения дубликатов используются следующие методики.

- Помощь встроенного функционала поисковиков. В Google для этой цели применяется атрибут rel="canonical". В коде каждой копии прописывается тег <link="canonical" href="http://site.ru/cat1/page.php">, указывающий на главную страницу, подлежащую индексации.

- Запрет на индексацию в файле robots.txt. Но данный способ не позволяет окончательно устранить дубли в поисковой системе. Для каждой страницы невозможно прописать параметры индексирования – лишь для групп из нескольких.

- Помощь 301-го редиректа. Он будет отправлять поисковики с копии на оригинальную страницу. В свою очередь, сервер 301 сделает пометку для роботов о том, что данной страницы (дубля) больше нет.

Дубликаты контента на сайте ухудшают его ранжирование. Если их оперативно не удалить, возрастает риск того, что сайт попадет под фильтрующие алгоритмы Panda и АГС.